Les synapses biologiques parviennent naturellement à équilibrer la rétention d’information et la plasticité d’apprentissage, tandis que les réseaux neuronaux artificiels peinent encore à surmonter l’oubli catastrophique et le rappel catastrophique. Nous présentons Métaplasticité issue de l’incertitude synaptique (MESU), une règle d’apprentissage pour les réseaux de neurones bayésiens qui ajuste chaque paramètre en fonction de son incertitude, permettant ainsi une combinaison cohérente de l’apprentissage et de l’oubli, sans nécessiter de délimitation explicite entre les tâches. MESU fournit également des estimations d’incertitude épistémique, favorisant une détection robuste des données hors distribution ; son principal coût réside dans le calcul : l’échantillonnage des poids pour les statistiques prédictives.

Sur plusieurs jeux de données de classification d’images, MESU atténue l’oubli tout en maintenant la plasticité d’apprentissage. Sur 200 tâches séquentielles de Permuted-MNIST, il surpasse les méthodes de consolidation synaptique existantes en termes de précision finale, de capacité à apprendre des tâches tardives et de détection des données hors distribution. Dans le cadre de CIFAR-100 à tâches incrémentales, MESU surpasse systématiquement les techniques d’apprentissage conventionnelles grâce à sa formulation continue, indépendante des délimitations entre les tâches. Sur le plan théorique, MESU établit un lien entre métaplasticité, inférence bayésienne et régularisation fondée sur la matrice Hessienne de la fonction de coût. Ensemble, ces résultats proposent une approche inspirée du fonctionnement biologique pour un apprentissage robuste et perpétuel.

Le cerveau humain apprend en permanence tout en préservant les connaissances acquises, un équilibre que les systèmes d’intelligence artificielle (IA) peinent encore à reproduire. Lorsqu’un modèle d’IA assimile de nouvelles informations, il tend souvent à effacer les savoirs précédemment acquis (un phénomène connu sous le nom d’oubli catastrophique) ou, au contraire, à devenir trop rigide pour intégrer de nouvelles données, ce qu’on appelle le rappel catastrophique.

Pour surmonter ce défi, nous nous sommes inspirés des neurosciences, où des travaux récents suggèrent que les synapses biologiques suivent des principes bayésiens : elles ajusteraient leurs représentations du monde en pondérant les nouvelles observations par rapport aux connaissances antérieures, tout en tenant compte de leur degré d’incertitude. Sur cette base, nous proposons un nouveau cadre d’apprentissage continu, appelé Métaplasticité issue de l’incertitude synaptique (MESU).

Dans MESU, chaque connexion du réseau agit comme une synapse bayésienne, maintenant sa propre estimation d’incertitude. Elle adapte ainsi sa vitesse d’apprentissage en fonction de la confiance accordée aux nouvelles informations, tout en intégrant un mécanisme d’oubli progressif pour les données jugées moins pertinentes. MESU traduit donc certaines hypothèses neuroscientifiques sur la manière dont le cerveau concilie stabilité de la mémoire et flexibilité cognitive.

Nos expériences montrent que MESU atteint un équilibre solide entre mémorisation et adaptation. Sur plusieurs jeux de données, incluant la classification d’images d’animaux, la reconnaissance de chiffres permutés et l’apprentissage incrémental d’objets, MESU réduit significativement à la fois l’oubli et la rigidité de l’apprentissage, tout en fournissant des estimations d’incertitude fiables. Il surpasse les méthodes d’apprentissage continu fondées sur la consolidation ou la séparation explicite des tâches.

Au-delà de ces résultats, MESU établit un lien théorique solide entre neurosciences et apprentissage automatique, en formalisant une approche inspirée du fonctionnement cérébral pour gérer l’apprentissage continu. Notre prochaine étape consistera à étendre MESU vers des modèles probabilistes compatibles avec le matériel embarqué, afin de rendre cet apprentissage continu bio-inspiré applicable à des dispositifs d’IA réels et à faible consommation d’énergie.

Références

Bonnet, D., Cottart, K., Hirtzlin, T., Januel, T., Dalgaty, T., Vianello, E. and Querlioz, D., 2025.

Bayesian continual learning and forgetting in neural networks. Nature Communications, 16 (1), p.9614.

https://doi.org/10.1038/s41467-025-64601-w

Affiliations

Centre de Nanosciences et de Nanotechnologies (C2N), CEA-LIST et CEA-LETI

Mots-clés : Apprentissage automatique, Réseaux de neurones artificiels, Apprentissage bayésien, Apprentissage continu, Métaplasticité, Incertitudes

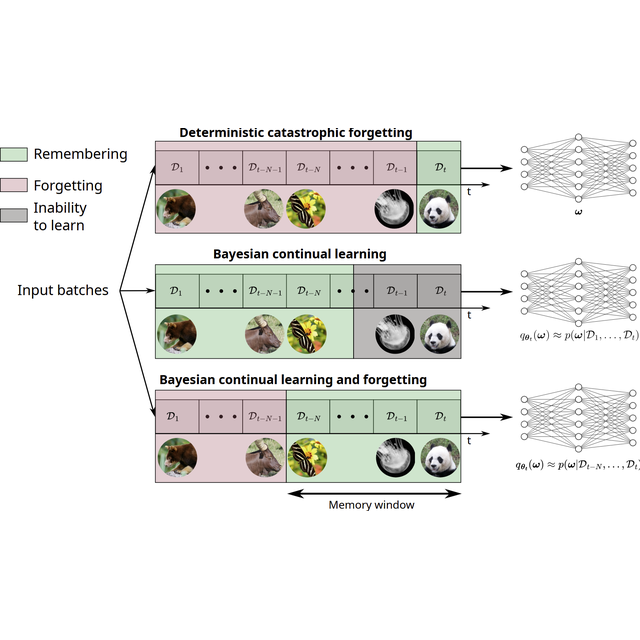

Figure : Bayesian continual learning and forgetting

L’apprentissage continu correspond à une situation d’entraînement séquentiel, dans laquelle plusieurs ensembles de données sont présentés successivement. Dans notre approche, les poids du réseau de neurones suivent une distribution de probabilité qui permet d’approximer une formulation conciliant de manière harmonieuse apprentissage et oubli, à la différence des méthodes précédentes.